«Росэлектроника» начала поставки на гражданский рынок коммуникационных адаптеров

Объединенный холдинг «Росэлектроника» (входит в Госкорпорацию Ростех) начал поставки на гражданский рынок коммуникационных адаптеров, способных объединять тысячи компьютеров в высокоскоростные сети для решения суперкомпьютерных задач в области аналитики, прогнозирования и проектирования.

Коммуникационная сеть с кодовым названием «Ангара» позволяет взаимодействовать вычислительным машинам, находящимся как в одном здании, так и на расстоянии в несколько тысяч километров друг от друга. При этом возможности «Ангары» практически безграничны — адаптеры позволяют концентрировать в единой сети мощности до 32 тысяч компьютеров (узлов), в том числе разных производителей и с разной архитектурой центральных процессоров.

Одним из первых гражданских заказчиков новой разработки стал Объединенный институт высоких температур (ОИВТ) РАН — ведущий научный центр России в области современной энергетики и теплофизики. Созданный для института 32-узловой вычислительный кластер с сетью «Ангара» направлен на решение задач в области молекулярной динамики.

«Разработка решает проблему дефицита вычислительных мощностей в отечественной промышленности и науке, — комментирует заместитель генерального директора объединенного холдинга „Росэлектроника“ Арсений Брыкин. — Создаваемые сети способны решать множество задач — от прогноза метеорологической обстановки до моделирования запуска космических аппаратов. Что важно, это делается без огромных вложений в строительство новых суперкомпьютерных объектов, на базе уже существующих мощностей».

Основой сети является сетевой адаптер (плата) на базе сверхбольшой интегральной схемы (СБИС) ЕС8430. По функциональности, производительности и надёжности «Ангара» сопоставима с современными разработками мировых лидеров в этой области — Cray, IBM, Mellanox. В составе «Росэлектроники» разработку и производство «Ангары» ведет московский «Научно-исследовательский центр электронной вычислительной техники» (НИЦЭВТ).

Кстати, а вы знали, что на «Сделано у нас» статьи публикуют посетители, такие же как и вы? И никакой премодерации, согласований и разрешений! Любой может добавить новость. А лучшие попадут в наш Телеграм @sdelanounas_ru. Подробнее о том как работает наш сайт здесь👈

Другие публикации по теме

- Холдинг «Росэлектроника» Госкорпорации Ростех освоил производст...аналогов и позволит отказаться от закупки иностранных материалов.

- Холдинг «Росэлектроника» Госкорпорации Ростех впервые представл...й DMR уровня Tier II+ для диапазонов частот 146-174 МГц и 401-486 МГц.

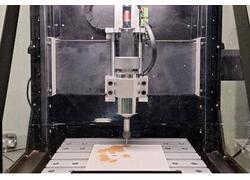

- Холдинг «Росэлектроника» Госкорпорации Ростех представил модерн...с, оргстекла, стеклотекстолита, дерева, МДФ, воска и цветных металлов.

Поделись позитивом в своих соцсетях

Maggey25.04.17 15:41:15