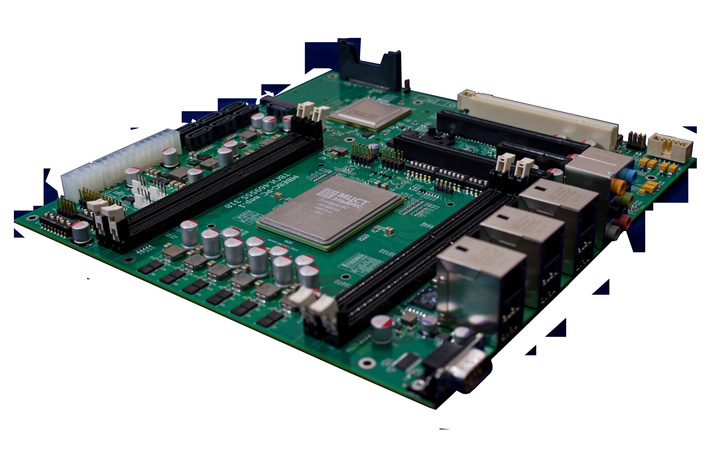

Фото дня! Материнская плата с процессором Эльбрус-8С

Поздравление с Новым Годом от директора компании МЦСТ Александра Кима.

Дорогие друзья, коллеги, соратники! Уходящий 2015-й год был трудным, он прошёл под знаком новых угроз и вызовов. Подтверждается правильность курса импортозамещения, выбранного руководством страны, с опорой на отечественные технологии.

Компания АО «МЦСТ» в кооперации с ПАО «ИНЭУМ им. И.С.Брука» в течение года вела активную работу по созданию отечественной вычислительной техники различных классов.

Кстати, а вы знали, что на «Сделано у нас» статьи публикуют посетители, такие же как и вы? И никакой премодерации, согласований и разрешений! Любой может добавить новость. А лучшие попадут в наш Телеграм @sdelanounas_ru. Подробнее о том как работает наш сайт здесь👈

Другие публикации по теме

- ГК «Бештау» объявила о начале производства микропроцессоро... часть поставляться в пределах страны», — отметил он.

- Холдинг «Росэлектроника» Госкорпорации Ростех изготовил и ...ударственные ведомства и предприятия оборонно-промышленного комплекса.

- Московская компания «АТБ Электроника» презентовала новую линейк...nbsp;также собирать и передавать данные на промышленных объектах.

Поделись позитивом в своих соцсетях

Комментарии 0